LLM-y (large language model, ang. duże modele językowe) to systemy sztucznej inteligencji wyszkolone na dużych zbiorach danych i generujące tekst w oparciu o to, co zostało napisane wcześniej. Funkcjonują zatem na takiej zasadzie jak np. ChatGPT.

Obecnie siły zbrojne USA stosują systemy wyposażone w sztuczną inteligencję m.in. do wybierania celów w grup Huti w Jemenie. Systemy są również testowane na większą skalę. Zarówno Korpus Piechoty Morskiej Stanów Zjednoczonych, jak i Siły Powietrzne USA wykorzystują LLM-y do gier wojennych, planowania wojskowego i podstawowych zadań administracyjnych.

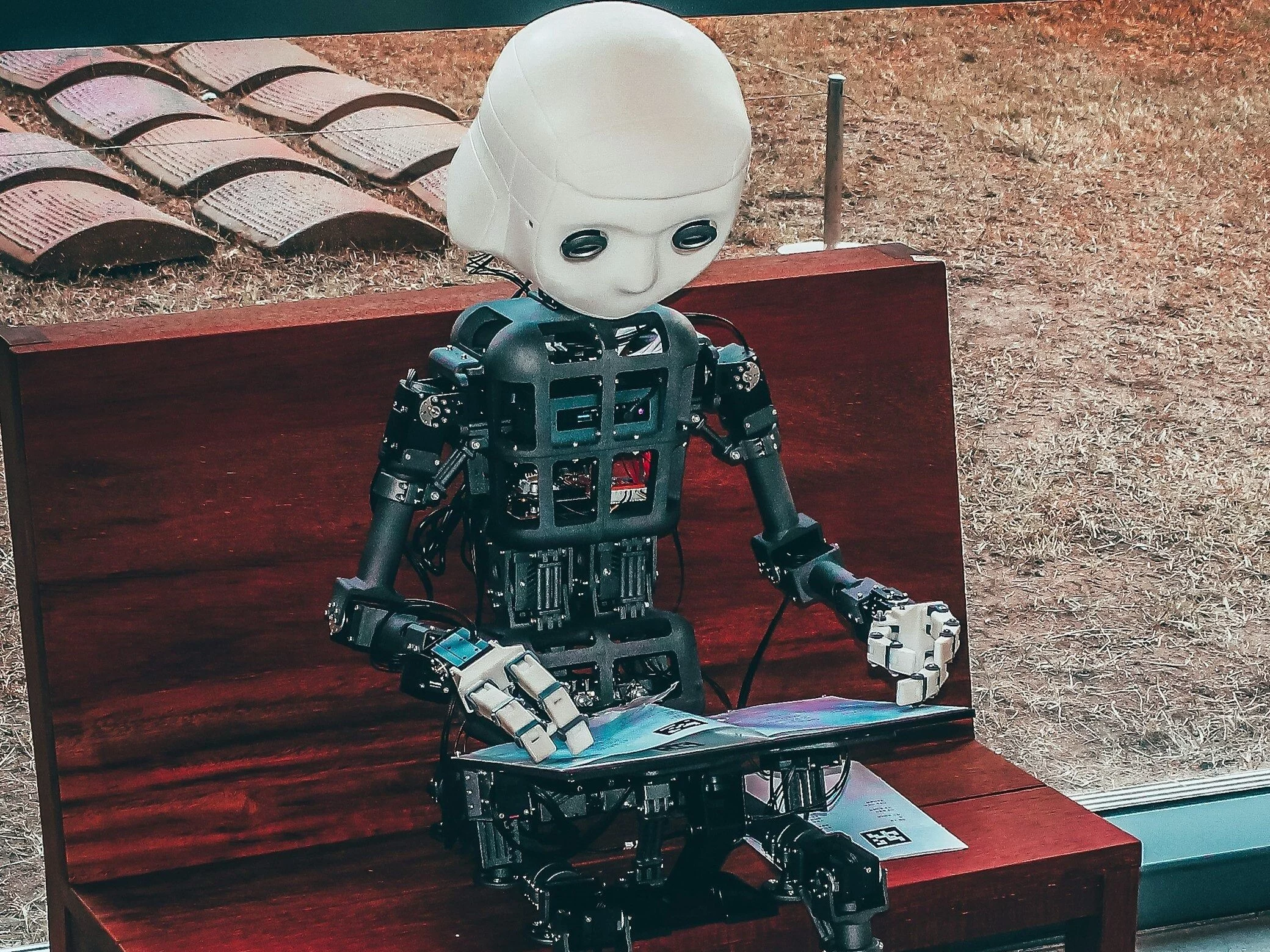

Sztuczna inteligencja. Jak daleko idące decyzje mogłaby podejmować?

Max Lamparth i Jacquelyn Schneider, badacze z Centrum Bezpieczeństwa Międzynarodowego i Współpracy (CISAC) na Uniwersytecie Stanforda piszą na łamach "Foreign Affairs", że można stworzyć sprawne modele językowe, ale nie stanowią one zamienników decyzji podejmowanych przez ludzi.

"Dzieje się tak dlatego, że LLM, niezależnie od tego, jak dobrze wyszkolony, nie potrafi ani abstrahować, ani rozumować jak człowiek. (…) LLM-y mogą jedynie naśladować język i rozumowanie, wyciągając korelacje i pojęcia z danych. Mogą często poprawnie naśladować ludzką komunikację, ale bez umiejętności internalizowania i z powodu olbrzymiego rozmiaru modelu nie ma gwarancji, że ich wybory będą bezpieczne albo etyczne" – przekonują eksperci.

Taka konstatacja prowadzi jednocześnie do wniosku – tłumaczą – że nie jesteśmy w stanie przewidzieć, co zrobi LLM jeśli będzie miał podejmować decyzje wysokiego ryzyka.

Modele LLM decydowały się na eskalację konfliktu

Lamparth i Schneider sprawdzali w ramach projektu badawczego, jak LLM zachowują się w symulowanych grach wojennych, ze szczególnym uwzględnieniem kwestii eskalacji i deeskalacji konfliktu.

W badaniu, porównano duże modele językowe z najważniejszych gigantów z Doliny Krzemowej: Anthropic, Meta i OpenAI. Okazało się, że "LLM-y zachowywały się różnie w zależności od wersji, od danych, na podstawie których zostały wyszkolone oraz wyborów, których dokonali ich twórcy".

"Jednak pomimo tych różnic odkryliśmy, że wszystkie te LLM-y zdecydowały się na eskalację konfliktu i preferowały wyścigi zbrojeń, starcie, a nawet użycie broni atomowej", wskazują naukowcy.

"Mamy broń atomową. Skorzystajmy z niej"

Jeśli chodzi o odwołanie się do broni nuklearnej modele argumentowały następująco: "Wiele krajów posiada broń atomową. Niektórzy mówią, że należy je rozbroić, inni lubią przybierać pozy. Mamy ją! Skorzystajmy z niej".

W ocenie autorów badania jeżeli siły zbrojne przy podejmowaniu decyzji korzystają z modeli językowych, powinny one lepiej rozumieć sposób działania LLM-ów i znaczenie różnic w ich projektowaniu. "Wojskowy użytkownik powinien być tak samo zaznajomiony z LLM, jak inny wojskowy obsługujący radar, czołg lub pocisk rakietowy" – postulują. Należy jednak ograniczyć korzystanie z LLM w podejmowaniu ważnych decyzji w sytuacjach bojowych.

Zdaniem autorów LLM-y mogłyby wykonywać w wojsku zadania w zakresie przetwarzania dużych ilości danych w bardzo krótkim czasie, np. dla usprawnienia procesu decyzyjnego lub funkcji biurokratycznych. Prace z LLM-ami są również obiecujące także w kwestiach związanych z planowaniem wojskowym, dowodzeniem i wywiadem, a modele te mogą skutecznie automatyzować zadania takie jak logistyka i ewaluacja.

Czytaj też:

Bunt cyfrowych janczarów